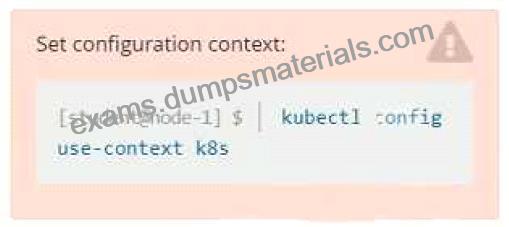

NR. 33 Ausstellen:

Kontext

Ein Pod läuft auf dem Cluster, aber er reagiert nicht.

Aufgabe

Das gewünschte Verhalten ist, dass Kubemetes den Pod neu startet, wenn ein Endpunkt einen HTTP 500 auf dem Endpunkt /healthz zurückgibt. Der Dienst probe-pod sollte niemals Datenverkehr an den Pod senden, wenn dieser ausfällt. Bitte führen Sie die folgenden Schritte aus:

* Die Anwendung hat einen Endpunkt, /started, der anzeigt, ob er Datenverkehr annehmen kann, indem er ein HTTP 200 zurückgibt. Wenn der Endpunkt ein HTTP 500 zurückgibt, hat die Anwendung ihre Initialisierung noch nicht abgeschlossen.

* Die Anwendung hat einen weiteren Endpunkt /healthz, der anzeigt, ob die Anwendung noch wie erwartet funktioniert, indem er ein HTTP 200 zurückgibt. Wenn der Endpunkt ein HTTP 500 zurückgibt, ist die Anwendung nicht mehr ansprechbar.

* Konfigurieren Sie den mitgelieferten probe-pod pod, um diese Endpunkte zu verwenden

* Die Sonden sollten den Port 8080 verwenden.